Band of browsers

Bienvenue sur IA-Pulse Weekend. Cette édition porte le numéro 133. En vous abonnant, vous recevez tous les samedis matin, l’essentiel de ce qu’il s’est passé cette semaine autour de l’IA : un coup de gueule édito, une sélection de 3 actualités avec pour chacune un résumé rapide à lire, plus 1 article de fond pour ouvrir l’esprit et réfléchir et 1 podcast à écouter. Gérez votre abonnement.

⏱️Temps de lecture de cette newsletter par une unité carbone : 9 mins

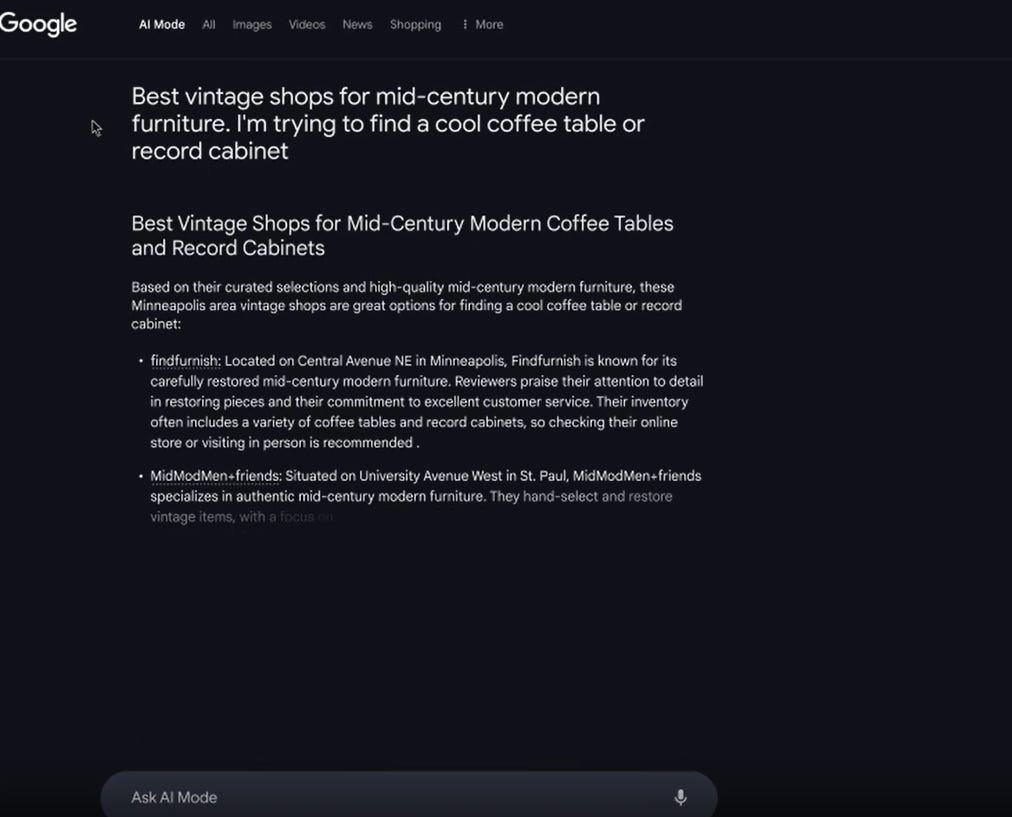

Atlas pour les uns, Comet pour tous. La guerre des navigateurs serait de nouveau déclarée. On se croirait revenu 20 ou 25 ans en arrière. La dernière bataille avait pris fin il y a 17 ans, quand Google avait offert son cheval au monde, en lançant Chrome. Et vous savez quoi ? Les principaux prétendants actuels au Trône sont tous construits à partir de Chromium, la base open-source de Chrome, maintenue par Google. Fin du simulacre de guerre.

Au delà de cette - mon - interprétation forcément éhontée, cette nouvelle Race des Seigneurs pose de nombreux problèmes. Le premier est celui de la sécurité. On ne compte déjà plus les mises en garde et les alertes des spécialistes. L’injection de prompt est devenue en quelques semaines le sport favori de nombreux acteurs en recherche de proies faciles. Encore plus simple que de manipuler ouvertement. Je serais actuellement RSSI d’une entreprise, j’interdirais l’usage de ces navigateurs dans mon organisation.

Faut-il pour autant les rejeter ces navigateurs tout mignons et excitants ? Non. Ils sont tellement attirants et nouveaux. Plein de vigueur. Ils savent faire des choses insoupçonnées. Mais il faut les cadrer, cadrer leurs usages, et surtout il faut cadrer leurs interfaces chaise-clavier d’humains. Ces nouveaux navigateurs dopés aux LLM, il faut les tester. Ils offrent de nouvelles aventures, de nouvelles perspectives, mais il faut les observer agir longuement avant de leur accorder plus de confiance. Dans le fond, ils sont aussi aussi manipulateurs que manipulables en sous-mains. Ils simulent nos actions de clics et nos recherches internet, et c’est déjà beaucoup. Ils savent déjà ce que nous aimons, ce que nous cherchons, ce qui nous fait du bien. Pourquoi vouloir alors leur donner tout de suite toutes les autres clés ? De nos comptes email aux login/password à nos outils personnels et professionnels ? Gardons, au moins pour le moment, quelques mystères pour les mémoires d’OpenAI et de Perplexity, et pour les yeux et mains des manipulateurs de prompts. Pour Google, c’est déjà trop tard, il n’y a plus de mystère depuis bien longtemps.

Cette semaine la partie de cette newsletter gérée par l’IA, les 3 clusters d’articles, a été générée par Gemini 2.5 Pro (temperature : 0.7) pour les résumés des articles sources, ainsi que la génération des clusters et des titres. Comme d’habitude j’ai fait quelques modifications, mais j’ai aussi laissé quelques tournures typiques des modèles de langage. Et bien entendu, mes commentaires éventuels sont en italique dans ces résumés. Le texte de “l’article qui fait réfléchir” est issu de Claude Sonnet 4.5.

L’image d’illustration ci-dessous a été générée par Midjourney

📰 Les 3 infos de la semaine

🖥️ OpenAI lance Atlas, un navigateur pour étendre l’emprise de ChatGPT

OpenAI a lancé Atlas, un nouveau navigateur web disponible sur Mac, avec des versions prévues pour Windows, iOS et Android. L’objectif principal de l’entreprise n’est pas tant d’améliorer la navigation web que de placer ChatGPT au centre de l’expérience utilisateur. Plutôt que de taper une recherche dans une barre d’adresse pour obtenir une liste de liens, Atlas propose d’interagir directement avec ChatGPT pour recevoir des réponses immédiates.

Le navigateur intègre des fonctionnalités avancées comme le “Mode Agent”, un système capable d’automatiser des tâches en naviguant sur plusieurs sites, en cliquant ou en remplissant des formulaires. Les tests montrent qu’il peut accomplir des missions complexes comme créer une playlist Spotify à partir d’une radio en ligne ou trouver le meilleur contrat d’électricité, mais il rencontre des difficultés avec des tâches plus longues principalement en raison de limites de temps de session.

Cependant, la fonctionnalité la plus notable est la “mémoire”. Atlas peut enregistrer non seulement l’historique de navigation, mais aussi des résumés du contenu des pages visitées pour personnaliser les futures interactions. Cette collecte de données soulève d’importantes questions de confidentialité. Les contrôles pour gérer ces “souvenirs” sont complexes, et des tests ont montré que des informations sensibles pouvaient être enregistrées.

Pourquoi est-ce important ? En tant que grand enthousiaste du B2A2C, je ne peux qu’être ébloui par ce genre d’interface. Pourtant, l’adoption ne se fera que si la confiance et donc la sécurité sont mises au centre des développements, pas comme une feature périphérique. Mais cela arrivera. Rappelez-vous, mettiez-vous votre numéro de CB sur internet au milieu des années 90 ? Et maintenant, hésitez-vous un seul instant ?

Pour aller plus loin : Ars Technica, TechCrunch, WP, The Verge, OpenAI

💵 “Help me decide” : le nouvel assistant d’achat IA d’Amazon

Amazon a lancé une nouvelle fonctionnalité nommée “Help me decide”. Disponible sur son application mobile et son site web aux États-Unis, cet outil vise à simplifier le processus d’achat en recommandant un produit spécifique à l’utilisateur. Après avoir consulté plusieurs articles similaires, un bouton apparaît, proposant une recommandation personnalisée.

Pour formuler sa suggestion, l’IA analyse l’activité de l’utilisateur : son historique de navigation, ses recherches, ses achats précédents et ses préférences. Par exemple, si un client a regardé des tentes et acheté du matériel de randonnée pour enfants, l’outil pourrait lui suggérer une tente quatre places adaptée au froid. En plus de la recommandation principale, le système propose une “option économique” et une “option supérieure”.

Cette fonctionnalité fait partie d’une tendance plus large où les géants de la technologie et du commerce cherchent à transformer l’IA d’un simple outil de recherche en un véritable assistant d’achat. D’autres acteurs comme Walmart, en partenariat avec OpenAI, et Google explorent des fonctionnalités similaires.

Pourquoi est-ce important ? A quand des produits sponso dans les recommandations “générées” par ces assistants ?

Pour aller plus loin : Axios, The Verge, TechCrunch, Amazon

🚦 Erreurs, sources manquantes : les assistants IA déforment l’actualité

Une étude menée par l’European Broadcasting Union (EBU) et la BBC révèle des défaillances importantes dans la manière dont les principaux assistants IA traitent l’information. L’analyse de près de 3 000 réponses de ChatGPT, Gemini, Copilot et Perplexity montre que 45 % d’entre elles contiennent au moins une erreur importante, et 81 % présentent au moins un problème mineur.

Le principal défaut concerne le sourcing : 31 % des réponses présentent des problèmes graves d’attribution, comme des sources manquantes, trompeuses ou incorrectes. Google Gemini affiche le taux d’erreur le plus élevé, avec des problèmes significatifs dans 76 % de ses réponses, suivi par Copilot (37 %), ChatGPT (36 %) et Perplexity (30 %). Des erreurs factuelles ont été relevées dans 20 % des cas, comme l’annonce de la mort du Pape plusieurs mois après l’événement ou la citation d’un article Wikipédia inexistant.

Ces assistants imitent le style journalistique avec un ton assuré, ce qui crée une “illusion de fiabilité” dangereuse. Le rapport souligne que ces erreurs nuisent non seulement à la perception de l’IA, mais aussi à la confiance envers les médias originaux. Une enquête révèle que 35 % des adultes britanniques estiment que la source d’information devrait être tenue responsable des erreurs générées par l’IA.

Pourquoi est-ce important ? Même si on peut critiquer la méthodologie de cette étude - et je suis de ceux qui porte un regard critique sur les conditions et la méthodologie de cette étude - et pour travailler quotidiennement sur ce sujet, il faut reconnaitre que les IA conversationnelles actuelles ne sont pas à la hauteur des enjeux de l’information dans nos sociétés. Mais peut-être qu’encore une fois, on demande des choses pour lesquelles ces modèles ne sont pas pensés. La faute à qui ? Principalement aux éditeurs de ces modèles et aux géants de l’IA qui encouragent ce type d’usages, et pensent pouvoir traiter l’information médiatique et factuelle comme une donnée quelconque. Le clé est peut-être ici.

Pour aller plus loin : Reuters, PressGazette, EBU

🚀 8 infos en plus

We uploaded a fake video to 8 social apps. Only one told users it wasn’t real (WP)

Instagram users can now use Meta AI editing tools directly in IG Stories (TechCrunch)

🧠Do Large Language Models Favor Recent Content? A Study on Recency Bias in LLM-Based Reranking (ArXiv)

🧠 Speech-to-Retrieval (S2R): A new approach to voice search (Google Research)

🧠 Scalable In-context Ranking with Generative Models (Google Research)

The Game Theory of How Algorithms Can Drive Up Prices (Quanta Magazine)

OpenAI Moves to Generate AI Music in Potential Rivalry With Startup Suno (The Information)

🛠️ Des outils, des tutos et des modèles à tester

Consensus : moteur de recherche universitaire alimenté par l’IA

Agentic AI’s Hidden Data Trail - and How to Shrink It : Six engineering habits curb data storage without curbing autonomy

Qwen’s new Deep Research update lets you turn its reports into webpages, podcasts in seconds

🧠 L’article qui fait réfléchir - et qu’il faut absolument lire

An AI app to measure pain is here

”Andromaque a le même battement de cils que Pénélope”

Comment mesurez-vous votre souffrance ? La douleur demeure l’une des expériences humaines les plus difficiles à quantifier. Malgré les avancées technologiques et l’émergence d’applications sophistiquées capables d’analyser les microexpressions faciales ou d’interpréter l’activité cérébrale, nous nous heurtons à une limite fondamentale : la subjectivité irréductible de la souffrance.

La douleur reste cette chose horriblement subjective, fluctuante, insaisissable. Comment comparer une appendicite à un orteil cassé ? Comment savoir si votre 6 sur 10 correspond au 6 de votre voisin ? Spoiler : c’est impossible. Nos expériences passées, nos humeurs du moment, nos attentes futures façonnent notre perception de la souffrance d’une manière totalement personnelle et chaotique - nous sommes chaos.

Chaque individu construit sa propre échelle de douleur à partir de son histoire personnelle, de ses traumatismes antérieurs et de son état psychologique du moment - comment est ta peine ? Ce qu’une personne qualifie de « douleur intense » peut correspondre à une sensation modérée pour une autre - Happiness in Slavery. Cette variabilité complique considérablement la tâche des professionnels de santé qui tentent d’évaluer et de traiter efficacement leurs patients. Les échelles numériques traditionnelles, bien qu’imparfaites, restent des outils de communication essentiels entre soignants et soignés - don’t shoot, let them burn !

Les technologies émergentes offrent pourtant des perspectives intéressantes, particulièrement pour les populations vulnérables incapables de verbaliser leur souffrance. Personnes âgées atteintes de troubles cognitifs, patients dans le coma ou jeunes enfants pourraient bénéficier d’outils d’évaluation objectifs. Toutefois, on peut se poser la question : peut-on réellement capturer et objectiver l’essence d’une expérience aussi intime et personnelle par des algorithmes ?

📻 Le podcast de la semaine

Andrej Karpathy — AGI is still a decade away

Andrej Karpathy estime que l’AGI encore loin : les agents actuels (Claude, Codex…) demeurent cognitivement déficients, sans mémoire ni apprentissage continu. L’évolution passera par des progrès lents — architectures, données, apprentissage réflexif — plutôt qu’un saut soudain ; l’IA prolongera l’automatisation, non une rupture.

N’hésitez à me contacter si vous avez des remarques et suggestions sur cette newsletter, ou si dans votre entreprise vous cherchez à être accompagnés dans l’intégration d’outils IA et d’IA générative : olivier@255hex.ai

Partagez cette newsletter

Et si vous n’êtes pas abonné, il ne tient qu’à vous de le faire !

“Tu as vu le destin s’intéresser à des phrases négatives ?” J. Giraudoux , 1935

Bon weekend